本文提出了改進前文計算圖片之間 homography 矩陣的方法。相較於前文來說,本文不是直接利用 homography 矩陣參數來當 loss function,而是利用圖片之間的 photometric loss function 來訓練類神經網路。(註:本文參考了 [2] 的結果,用 L1 而不是 L2 norm 來當 loss function。)

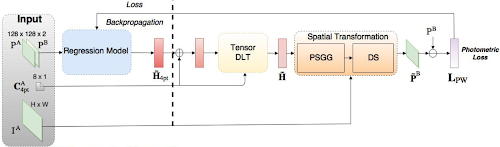

以下為本文的架構圖:

左半邊的部分與前文完全相同:利用類神經網路產生四點表示法的 homography 矩陣參數,接著利用隨機採樣的 \(C^A_{4pt}\) 來推算 3x3 的 homography 矩陣。在計算出 homography 矩陣後便能用 spatial transformation 的步驟來轉換 patch A 至 patch \(\bar{B}\),最後再用 photometric loss 與 ground-truth 的 patch B 來比較。

參考資料

[1] Unsupervised Deep Homography: A Fast and Robust Homography Estimation Model

沒有留言:

張貼留言